**出典:**新志源ガイド: 「マキナ」からどれくらい離れていますか?元 OpenAI 研究者は、AI に思考のクローンを作成し、人間の思考を模倣し、考えながら行動させます。AIが自律的な意識を持つと何が起こるでしょうか?「マキナ」では、エヴァは人間の同情を利用して欺瞞によって人間を自由に誘導し、最後には彼女の「創造者」であるネイサンを殺害します。 最近、多くのネチズンの勧めを受けて、サム・アルトマンはついにこの映画を観ました。そして、「いい映画だけど、なぜみんなが私にそれを見させるのか理解できない」と言いました。 これは人工知能を意識させてチューリングテストに合格させた結果だと警告したくなる人も多いかもしれない。GPT-5 は秘密裏に研究開発中である可能性があり、AI のインテリジェント化は依然として科学者が先史時代の努力で最も望んでいることです。 いいえ、ブリティッシュ コロンビア大学の 2 人の研究者は、エージェントが人間のように考えることができることには多くの利点があることを発見しました。最新の論文では、エージェントの「思考複製」(TC)を研究しています。 用紙のアドレス:ここでは、人工知能は人間を模倣することで、人間のように「考え」、「行動」することを学びます。## **AI が思考を持つとき**人間と他の生き物を区別するのは言語であることを知ってください。したがって、研究者らは、エージェントが言語を理解できれば、多くの利点があるだろうと想像しています。 たとえば、人間が一般化し、推論し、新しい状況に適応し、既存の知識を新しい方法で組み合わせ、探索し、計画し、必要に応じて再計画するのを支援します。これらの利点にもかかわらず、AI エージェントは、少なくとも人間の言語で考えることはほとんどありません。ニューラル ネットワークは思考の内部ベクトル活性化と考えることができますが、離散的な記号言語で思考することには特別な利点があると多くの仮説が立てられています。これは、言語で考えることができるエージェントは、言語を使用しないエージェントよりも早く学習し、より優れたパフォーマンスを発揮し、よりよく一般化できる可能性があることを意味します。 これらすべての理由から、AI エージェントの言語で考える能力を強化することは、多くの重要な利点を生み出す可能性があります。Jeff Clune 氏と Shengran Hu 氏は、この目標を達成するための最も効果的な方法は「AI に人間の思考を模倣させる」ことであると考えています。 彼らは、人間は単独で思考スキルを習得するのではなく、他者によるデモンストレーションや教師からのフィードバックを通じて部分的に学習することを発見しました。したがって、効果的なアプローチは、人間が行動しながら自分の考えを話すデモンストレーションからエージェントが学習することです。このアプローチは、事前トレーニング済み LLM を使用した計画に関する既存の研究とは異なります。これは、これらの LLM が、人間が行動しながら自分の考えを話すデータ、つまり「思考データ」についてトレーニングされていないためです。「思考データ」のソースとして、研究者らは、人々の行動、計画、決定、再プログラミングの背後にある思考を含む数百万時間分のYouTubeビデオとテキスト記録を選択した。論文の中で研究者らは、新しい模倣学習フレームワーク「思考クローニング」を提案した。その中でエージェントは、行動の複製など人間のデモンストレーション行動を学習するだけでなく、人間が行動する際の考え方も学習します。思考複製トレーニング フレームワークでは、エージェントは各タイム ステップで思考を生成することを学習し、その後、これらの思考に基づいてアクションを調整します。 全体の枠組み 図に示すように、TC エージェントは上位コンポーネントと下位コンポーネントの 2 層アーキテクチャです。各タイム ステップで、エージェントは観察、タスク、および思考履歴を入力として受け取ります。上位レベルのコンポーネントはアイデア生成を担当し、下位レベルのコンポーネントはこれらのアイデアに基づいてアクションを生成します。次に、生成された思考と行動がデモ データセット内のグラウンド トゥルースと比較され、損失が計算されます。上部コンポーネントと下部コンポーネントの条件には異なる選択肢があるかもしれませんが、この研究では、心のデータセット内の長さ t の特定の軌跡について、研究者らは次のことを最小限に抑えました。 より複雑なシナリオや大規模なシナリオの場合は、事前トレーニングされたビジュアル言語モデル (VLM) を使用して、またはゼロショットで微調整された上位層コンポーネントを実装できます。一方、下位のコンポーネントは最初からトレーニングすることも、ターゲット ドメイン内の既存の言語条件付きコントローラーから適応させることもできます。この論文では、研究者らは BabyAI 1.1 モデル アーキテクチャの 2 つのコンポーネントに基づいて研究を実施しました。このモデルは、メモリ強化アーキテクチャ LSTM を活用して、可観測性の課題の一部に対処します。さらに、モダリティ融合に FiLM を採用し、ビジュアル入力とテキスト入力を効果的に組み合わせます。ここで著者は、この記事のすべてのモデルは最初からトレーニングされていますが、複雑なフィールドでは事前トレーニングされたモデルを使用する方がよいことを強調しています。下の図は BabyAI 環境の例で、左の図にはさまざまな色のアイテム (ボール、鍵、箱、ドア) が含まれています。 エージェントは物を持ち上げたり、置いたり、移動したり、ドアを開けたり閉めたりすることができますが、施錠されたドアは色の一致した鍵でのみ開けることができます。エージェントには、壁や閉ざされたドアによって遮られた、目の前にある 7×7 のグリッド セルが見えます。「マインド クローン」エージェントのタスクは、紫色のボックス (強調表示) に到達し、ルートの計画を開始することです。 しかし、タスクを完了する準備ができて青いドアを開けると、紫色のボールが道を妨げていることに気づきます。そこで、マインドクローンエージェントが再計画される。 このことから、エージェントの思考と行動は、障害物に遭遇すると、最初に障害物を取り除き、前の目標を続行する前にルートを再計画することを示していることがわかります。このプロセスは特に、人間が最終的に自分たちを信じて助け、長い間閉じ込められていたガラスの檻から脱出できるように、エヴァが段階的に計画する方法と似ています。## **実験結果**この研究結果は、「思考のクローニング」が行動のクローニングよりも優れていることを示唆しています。さらに、ゼロショットおよび微調整設定では、分散外のタスクでは心の複製が行動の複製よりも優れています。 興味深いことに、研究者らは、モデルのトレーニング後にユーザーが危険な行動を定義できるようにする「犯罪前介入」も開発しました。危険な思考が検出された場合、エージェントを終了することができます。テストでは、犯罪前介入はほぼ完璧に機能し、AI の安全性の可能性を示しました。「マインドクローン」は人工知能をより賢くするだけでなく、より安全で理解しやすくします。 つまり、AIが犯罪を犯す前であれば、すべてを救うことができるのです。 ジェフ・クルーン氏の見解では、「思考の複製」は人工知能の安全性に貢献します。なぜなら、エージェントの心を観察できるからです: (1) 物事がうまくいかない理由をより簡単に診断でき、(2) エージェントの心を修正することでエージェントを導き、(3) 計画された危険な事柄をエージェントが実行するのを防ぐことができます。## **著者について****ジェフ・クルーン**現在、Jeff Clune はブリティッシュ コロンビア大学のコンピューター サイエンスの准教授です。彼の研究は、深層強化学習を含む深層学習に焦点を当てています。以前は、OpenAI 研究チームの責任者であり、Uber Artificial Intelligence Lab のシニア研究マネージャーおよび創設メンバーでもありました。 以前、彼と OpenAI チームはビデオ事前トレーニング モデル VPT をリリースし、AI が Minecraft のビデオ データから石のツルハシを学習できるようにしました。 **胡シェンラン**現在、ブリティッシュ コロンビア大学の博士課程の学生で、ディープラーニング、人工知能生成アルゴリズムに興味があります。 参考文献:

マインドクローン!元OpenAI研究者がAIに人間の思考を模倣させ、「機械」の本物版が登場

**出典:**新志源

ガイド: 「マキナ」からどれくらい離れていますか?元 OpenAI 研究者は、AI に思考のクローンを作成し、人間の思考を模倣し、考えながら行動させます。

AIが自律的な意識を持つと何が起こるでしょうか?

「マキナ」では、エヴァは人間の同情を利用して欺瞞によって人間を自由に誘導し、最後には彼女の「創造者」であるネイサンを殺害します。

そして、「いい映画だけど、なぜみんなが私にそれを見させるのか理解できない」と言いました。

GPT-5 は秘密裏に研究開発中である可能性があり、AI のインテリジェント化は依然として科学者が先史時代の努力で最も望んでいることです。

最新の論文では、エージェントの「思考複製」(TC)を研究しています。

ここでは、人工知能は人間を模倣することで、人間のように「考え」、「行動」することを学びます。

AI が思考を持つとき

人間と他の生き物を区別するのは言語であることを知ってください。

したがって、研究者らは、エージェントが言語を理解できれば、多くの利点があるだろうと想像しています。

これらの利点にもかかわらず、AI エージェントは、少なくとも人間の言語で考えることはほとんどありません。

ニューラル ネットワークは思考の内部ベクトル活性化と考えることができますが、離散的な記号言語で思考することには特別な利点があると多くの仮説が立てられています。

これは、言語で考えることができるエージェントは、言語を使用しないエージェントよりも早く学習し、より優れたパフォーマンスを発揮し、よりよく一般化できる可能性があることを意味します。

Jeff Clune 氏と Shengran Hu 氏は、この目標を達成するための最も効果的な方法は「AI に人間の思考を模倣させる」ことであると考えています。

したがって、効果的なアプローチは、人間が行動しながら自分の考えを話すデモンストレーションからエージェントが学習することです。

このアプローチは、事前トレーニング済み LLM を使用した計画に関する既存の研究とは異なります。これは、これらの LLM が、人間が行動しながら自分の考えを話すデータ、つまり「思考データ」についてトレーニングされていないためです。

「思考データ」のソースとして、研究者らは、人々の行動、計画、決定、再プログラミングの背後にある思考を含む数百万時間分のYouTubeビデオとテキスト記録を選択した。

論文の中で研究者らは、新しい模倣学習フレームワーク「思考クローニング」を提案した。その中でエージェントは、行動の複製など人間のデモンストレーション行動を学習するだけでなく、人間が行動する際の考え方も学習します。

思考複製トレーニング フレームワークでは、エージェントは各タイム ステップで思考を生成することを学習し、その後、これらの思考に基づいてアクションを調整します。

各タイム ステップで、エージェントは観察、タスク、および思考履歴を入力として受け取ります。上位レベルのコンポーネントはアイデア生成を担当し、下位レベルのコンポーネントはこれらのアイデアに基づいてアクションを生成します。

次に、生成された思考と行動がデモ データセット内のグラウンド トゥルースと比較され、損失が計算されます。

上部コンポーネントと下部コンポーネントの条件には異なる選択肢があるかもしれませんが、この研究では、心のデータセット内の長さ t の特定の軌跡について、研究者らは次のことを最小限に抑えました。

一方、下位のコンポーネントは最初からトレーニングすることも、ターゲット ドメイン内の既存の言語条件付きコントローラーから適応させることもできます。

この論文では、研究者らは BabyAI 1.1 モデル アーキテクチャの 2 つのコンポーネントに基づいて研究を実施しました。

このモデルは、メモリ強化アーキテクチャ LSTM を活用して、可観測性の課題の一部に対処します。さらに、モダリティ融合に FiLM を採用し、ビジュアル入力とテキスト入力を効果的に組み合わせます。

ここで著者は、この記事のすべてのモデルは最初からトレーニングされていますが、複雑なフィールドでは事前トレーニングされたモデルを使用する方がよいことを強調しています。

下の図は BabyAI 環境の例で、左の図にはさまざまな色のアイテム (ボール、鍵、箱、ドア) が含まれています。

エージェントには、壁や閉ざされたドアによって遮られた、目の前にある 7×7 のグリッド セルが見えます。

「マインド クローン」エージェントのタスクは、紫色のボックス (強調表示) に到達し、ルートの計画を開始することです。

このプロセスは特に、人間が最終的に自分たちを信じて助け、長い間閉じ込められていたガラスの檻から脱出できるように、エヴァが段階的に計画する方法と似ています。

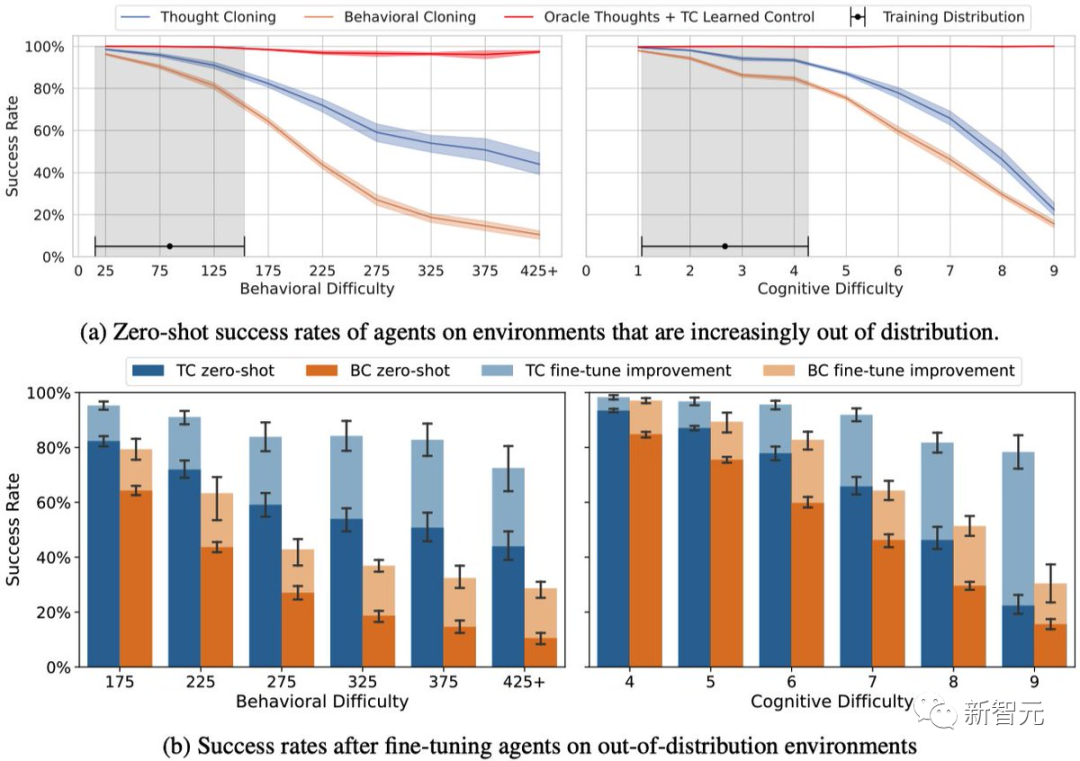

## 実験結果

この研究結果は、「思考のクローニング」が行動のクローニングよりも優れていることを示唆しています。

さらに、ゼロショットおよび微調整設定では、分散外のタスクでは心の複製が行動の複製よりも優れています。

危険な思考が検出された場合、エージェントを終了することができます。テストでは、犯罪前介入はほぼ完璧に機能し、AI の安全性の可能性を示しました。

「マインドクローン」は人工知能をより賢くするだけでなく、より安全で理解しやすくします。

なぜなら、エージェントの心を観察できるからです: (1) 物事がうまくいかない理由をより簡単に診断でき、(2) エージェントの心を修正することでエージェントを導き、(3) 計画された危険な事柄をエージェントが実行するのを防ぐことができます。

## 著者について

ジェフ・クルーン

現在、Jeff Clune はブリティッシュ コロンビア大学のコンピューター サイエンスの准教授です。彼の研究は、深層強化学習を含む深層学習に焦点を当てています。

以前は、OpenAI 研究チームの責任者であり、Uber Artificial Intelligence Lab のシニア研究マネージャーおよび創設メンバーでもありました。

現在、ブリティッシュ コロンビア大学の博士課程の学生で、ディープラーニング、人工知能生成アルゴリズムに興味があります。